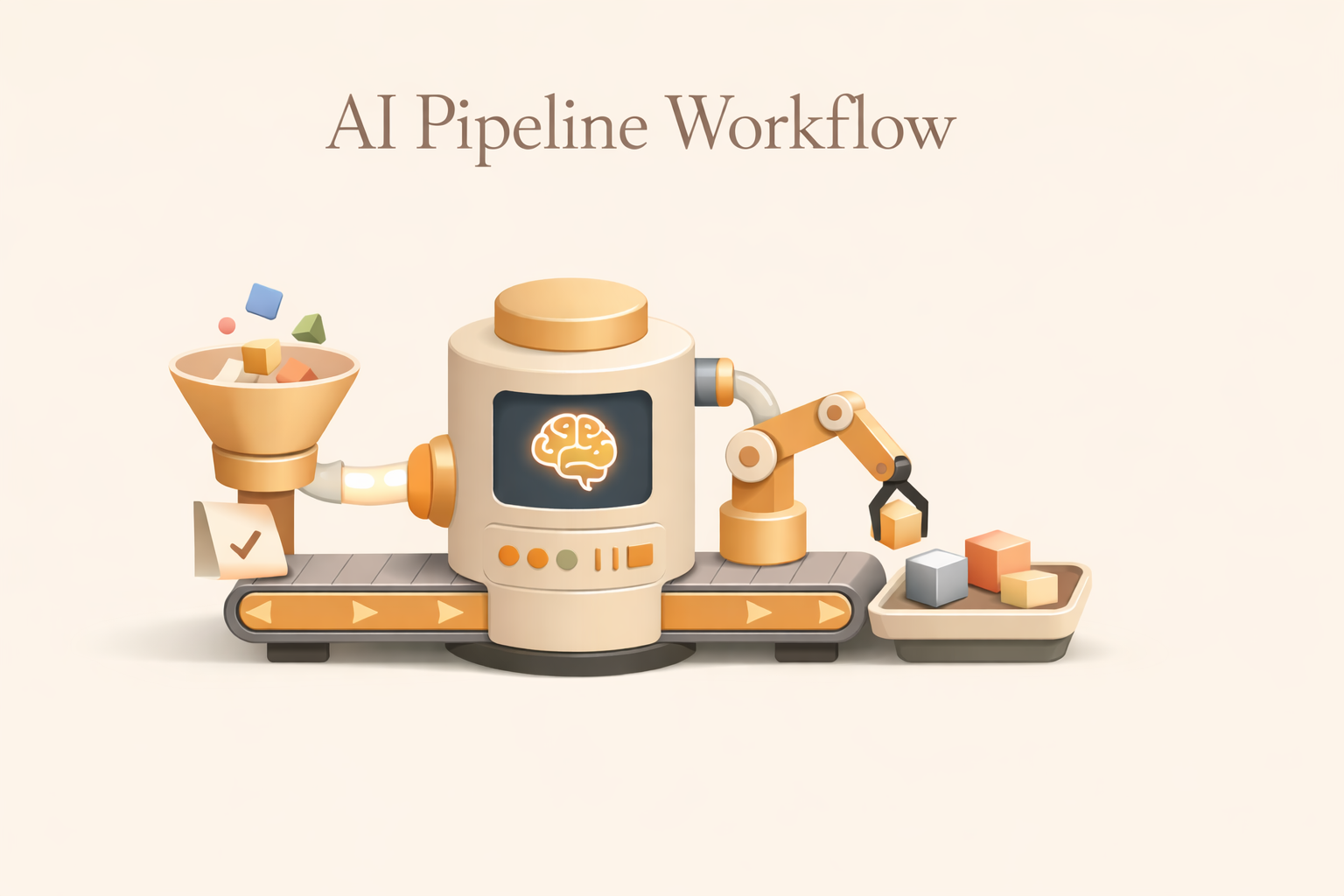

AI パイプラインワークフロー:その内容と仕組み

AI パイプラインワークフローとは何か、データの取り込みから展開、監視に至るまで、エンドツーエンドでどのように機能するか、プロトタイプだけでなく信頼性の高いモデルを本番環境にも投入する AI パイプラインを設計する方法を学びましょう。

AI パイプラインワークフローとは

AI パイプラインワークフローは、生データを本番環境で使用可能な AI 機能に変換する、構造化された自動システムです。AI パイプラインワークフローは、切り離されたスクリプト、壊れやすいノートブック、手動でトリガーされるジョブに頼るのではなく、取り込み、変換、モデリング、デプロイ、継続的な監視を通じてデータを確実に移動させる、繰り返し可能な一連の段階を定義します。

実用的なレベルでは、AIパイプラインは非常に一般的な問題、つまり実験と生産の間のギャップを解決するために存在します。多くの組織は、単独でも十分に機能するモデルを構築できますが、実際のビジネスワークフロー内でそのモデルを継続的に運用できる組織ははるかに少ないです。AI パイプラインワークフローは、データの準備、トレーニング、検証、提供、再トレーニングといったすべてのステップを一貫して、観察可能に、かつ大規模に実行できるようにすることで、このギャップを埋めます。

適切に設計されたパイプラインは、各フェーズを独立しているが接続されたシステムとして扱います。データの取り込みは自動化されており、上流側の変更にも柔軟に対応できます。検証によって品質ゲートが強化されるため、破損したデータや不完全なデータがモデルに届くことはありません。フィーチャーエンジニアリングは、トレーニングと推論が一致するように標準化されています。トレーニングと評価は、手動による介入ではなく、データの最新性やパフォーマンスの閾値に基づいて行われます。デプロイメント・メカニズムにより、予測が下流のシステムに確実に届くようになります。モニタリングによってループが終了し、ドリフトが検出され、必要に応じて再トレーニングが開始されます。

もし AI ワークフロー チケットのルーティング、製品の価格設定、リスクのスコアリング、コンテンツの生成など、ビジネスが何をしているのかを表し、AIパイプラインのワークフローはインテリジェンスの作成と維持の方法を表します。舞台裏に信頼できるパイプラインがないと、最も高度な AI ワークフローでさえ、時間が経つにつれて劣化し、最終的には機能しなくなります。

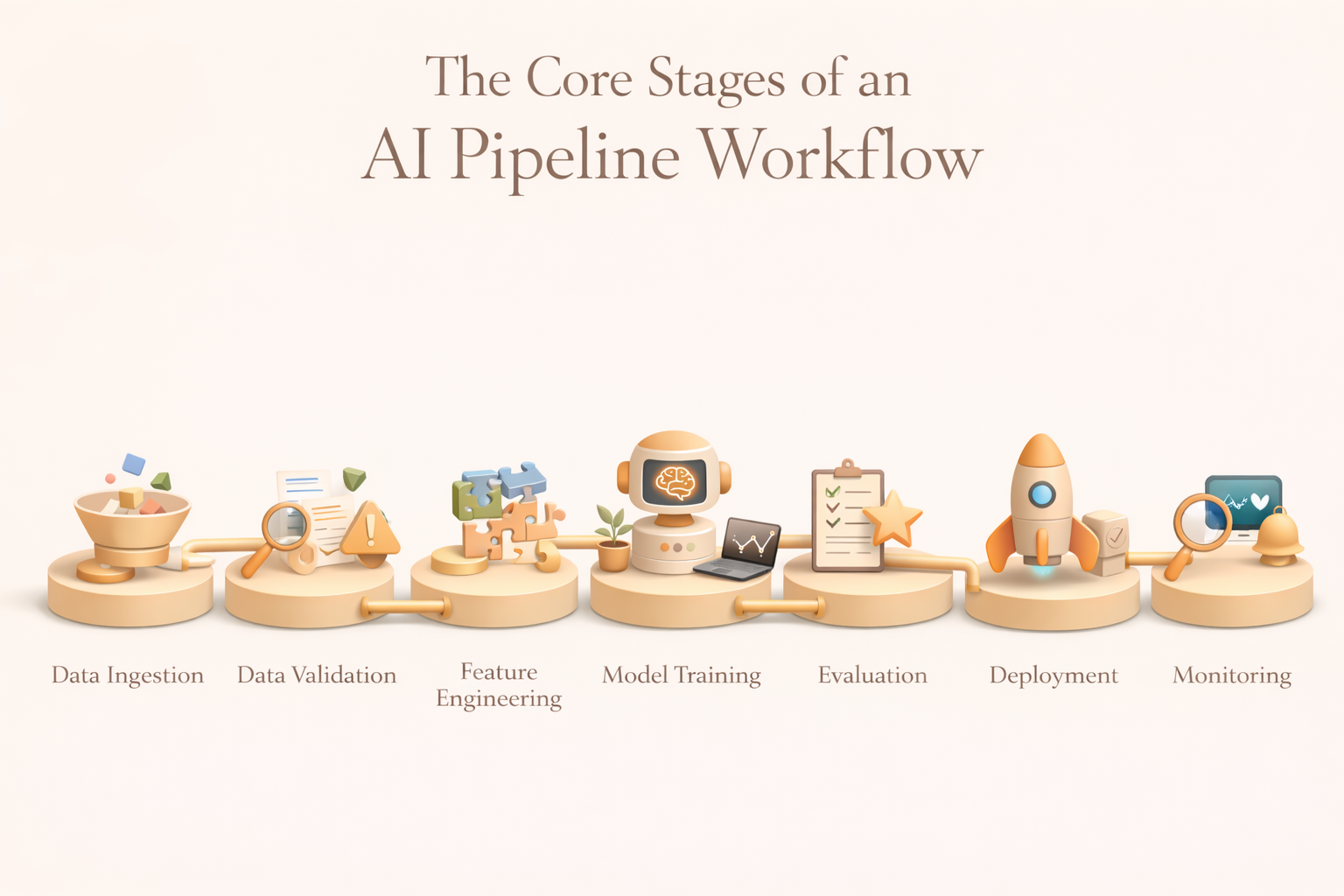

AI パイプラインワークフローのコアステージ

ツールや実装はさまざまですが、ほとんどのプロダクションAIパイプラインは一貫した構造に従っています。各段階には理由があり、どの段階の弱点も下流で悪化します。

1。データ取り込み

データインジェストはパイプラインのエントリポイントです。その役割は、複数のソースから生データを確実に収集し、下流処理を行える制御された環境に配信することです。

一般的なソースには、トランザクションデータベース、イベントストリーム、クラウドストレージ、SaaS アプリケーション、ログ、センサー、外部 API などがあります。Effective Ingestはスキーマの進化に対応し、バッチモードとストリーミングモードをサポートし、配信と完全性を保証します。成熟したチームは、データレイクやウェアハウスに取り込みを一元化して、信頼できる唯一の情報源を確立し、システム間の連携を減らします。

2。データ検証と前処理

未加工データをそのまま使用できることはほとんどありません。検証と前処理を行うことで、値の欠落、スキーマのずれ、重複、レコードの破損が原因で発生するサイレント障害からパイプラインを保護できます。

この段階では、品質上の制約を適用し、フォーマットを標準化し、ノイズを除去し、必要に応じてプライバシーやコンプライアンスの変革を適用します。重要なのは、検証が自動化されていることです。異常が定義されたしきい値を超えると、パイプラインは実行を一時停止したり、所有者に警告したり、データをルーティングして手動で確認したりできます。これにより、データ品質は後から考えたものから運用上の保証へと変わります。

3。フィーチャー・エンジニアリング

フィーチャーエンジニアリングは、クリーンアップされたデータをモデルが学習できる信号に変換します。これには、イベントを集約してユーザーレベルのメトリクスにしたり、カテゴリ変数をエンコードしたり、テキストや画像から埋め込みを生成したり、時間枠にわたるローリング統計を計算したりすることが含まれる場合があります。

実稼働環境では、機能エンジニアリングがアドホックになることはめったにありません。チームはフィーチャストアを使用して定義を標準化し、トレーニングと推論の一貫性を保ち、モデル間での再利用を可能にします。これにより、技術的な負債が減り、予測が無効になるようなトレーニングサービスの微妙な偏りを防ぐことができます。

4。モデルトレーニング

トレーニングステージは、準備された機能を使用するモデルに適合します。これには多くの場合、データセットの分割、候補モデルトレーニング、ハイパーパラメーターの最適化、アーティファクトのロギングが含まれます。

トレーニングは、固定スケジュールで実行される場合もあれば、新しいデータ量によってトリガーされる場合もあれば、モニタリングで検出されたパフォーマンスの低下に対応する場合もあります。重要なのは、トレーニングのアウトプットをバージョン管理して追跡することで、チームが結果を再現し、意思決定を監査し、必要に応じてロールバックできるようにすることです。

5。評価、ガバナンス、承認

導入前に、モデルを技術的、ビジネス的、倫理的な基準に照らして評価する必要があります。これには、精度指標、安定性チェック、公平性評価、コストやリスクの閾値などのビジネス上の制約が含まれます。

多くのパイプラインは、この段階で承認ゲートを強制します。モデルが事前定義された基準を満たさない場合、デプロイは自動的にブロックされます。これにより、ガバナンスを遡及的に実施するのではなく、パイプラインにガバナンスを組み込むことが保証されます。

6。デプロイ

デプロイメントは、承認されたモデルを実際のシステムの予測を生成できる環境にパッケージ化します。ユースケースによっては、バッチスコアリング、リアルタイム API、ストリーミング推論などが含まれる場合があります。

オーケストレーションフレームワークは、上流のデータパイプラインと下流のアプリケーションとのモデルサービスを調整します。ここでは、信頼性、レイテンシー、ロールバック戦略が重要です。デプロイの失敗はビジネスワークフローに直接影響します。

7。モニタリング、ドリフト検出、再トレーニング

いったん導入されると、パイプラインは継続的な監視に移行します。モニタリングは、データドリフト、モデルのパフォーマンス、運用の健全性、コストを追跡します。指標が劣化したり、分布が変化したりすると、パフォーマンスを回復するために再トレーニングワークフローがトリガーされます。

この最終段階では、AIは静的な人工物から、状況の変化に適応する生きたシステムに変わります。

AI パイプラインステージの概要

AI パイプラインワークフロー設計のベストプラクティス

1。パイプラインを 1 回限りのスクリプトではなく、コードとして設計する

プロダクションパイプラインは、バージョン管理され、テスト可能で、レビュー可能でなければなりません。パイプラインをコードとして扱うことで、再現性、コラボレーション、アカウンタビリティを確保できます。Git に保存されたワークフロー定義により、チームは変更を追跡し、決定を監査し、安全にロールバックすることができます。この規律により、組織の知識がノートブックや個々のマシンにとらわれるのを防ぐことができます。

2。明確な契約書で明確なステージ境界線を作る

パイプラインの各ステージでは、明示的な入力と出力を公開する必要があります。これらの契約によりシステムがモジュール化され、カスケード障害が減少します。境界が明確になれば、チームは取り込みを中断することなくモデルを反復処理したり、デプロイを中断することなく機能ロジックを置き換えたりできます。障害が切り離されるので、デバッグが速くなります。

3。モニタリングを初日からパイプラインに組み込む

モニタリングはオプションのアドオンではありません。パイプラインは、すべての段階でデータ品質、パフォーマンス、レイテンシー、エラーに関するメトリクスを出力する必要があります。アラートシステムは、障害がユーザーに影響を及ぼす前にチームに通知する必要があります。現場の真実を把握するフィードバックループにより、再トレーニングと継続的な改善が可能になります。監視しなければ、パイプラインは静かに減衰します。

4。パイプラインの動作をビジネス SLA やワークフロー要件に合わせる

パイプラインはビジネスワークフローをサポートするために存在します。顧客とのリアルタイムなやりとりには低レイテンシーの推論が必要ですが、財務報告ではバッチ遅延を許容できる場合があります。これらの制約を事前に理解しておくことで、インフラストラクチャーの選択、オーケストレーション戦略、コストのトレードオフがわかります。成功するパイプラインは、ツールからではなく、ワークフローのニーズから逆算して設計されています。

5。導入だけではなく進化のための計画

AI システムは、データの増加、市場の変化、モデルの改善とともに進化します。パイプラインは、完全に書き直すことなく、スキーマの変更、新しいシグナル、モデルのアップグレードに対応できなければなりません。モジュール設計、標準化されたインターフェイス、拡張可能なオーケストレーションロジックにより、長期的な速度を確保し、リエンジニアリングコストを削減できます。

AI パイプラインワークフローと AI ワークフロー自動化

結論

AI パイプラインワークフローは、プロダクション AI の運用上のバックボーンです。分散したデータや実験モデルを、実際の意思決定を大規模に行える信頼性の高いシステムに変換します。パイプラインが適切に設計されれば、リスクが軽減され、イテレーションが加速され、AI ワークフローが長期にわたって正確で信頼できる状態を維持できるようになります。

AIが日常業務に組み込まれるにつれて、次のようなプラットフォームが 久瀬 パイプラインのアウトプット(要約、予測、洞察)をコラボレーションワークスペースに直接取り込むことで、補完的な役割を果たします。パイプラインが取り込み、トレーニング、モニタリングを舞台裏で処理するのに対し、Kuse は人々が実際に働いている場所でインテリジェンスを明らかにすることで、機械学習インフラストラクチャと人間の意思決定の間のギャップを埋めます。

現代のAIシステムでは、パイプラインはインテリジェンスを可能にしますが、慎重な統合によってそれを使用できるようになります。