Flusso di lavoro della pipeline AI: cos'è e come funziona

Scopri cos'è un flusso di lavoro di una pipeline di intelligenza artificiale, come funziona end-to-end, dall'inserimento dei dati all'implementazione e al monitoraggio, e come progettare pipeline di intelligenza artificiale che inviino modelli affidabili in produzione, non solo prototipi.

Che cos'è un flusso di lavoro di AI Pipeline?

Un flusso di lavoro di pipeline AI è il sistema strutturato e automatizzato che trasforma i dati grezzi in una capacità di intelligenza artificiale pronta per la produzione. Anziché affidarsi a script disconnessi, notebook fragili o processi attivati manualmente, un flusso di lavoro basato su una pipeline di intelligenza artificiale definisce una sequenza ripetibile di fasi che trasferiscono i dati in modo affidabile attraverso l'acquisizione, la trasformazione, la modellazione, l'implementazione e il monitoraggio continuo.

A livello pratico, esistono pipeline di intelligenza artificiale per risolvere un problema molto comune: il divario tra sperimentazione e produzione. Molte organizzazioni possono creare un modello che funziona bene da solo, ma molte meno sono in grado di utilizzarlo continuamente all'interno di flussi di lavoro aziendali reali. Un flusso di lavoro basato sull'intelligenza artificiale colma questa lacuna garantendo che ogni fase (preparazione, formazione, convalida, gestione e riqualificazione dei dati) venga eseguita in modo coerente, osservabile e su larga scala.

Una pipeline ben progettata tratta ogni fase come un sistema indipendente ma connesso. L'inserimento dei dati è automatizzato e resistente alle modifiche a monte. La convalida applica i criteri di qualità in modo che i dati danneggiati o incompleti non raggiungano mai i modelli. L'ingegneria delle funzionalità è standardizzata in modo che l'addestramento e l'inferenza rimangano allineati. La formazione e la valutazione sono innescate dall'aggiornamento dei dati o dalle soglie prestazionali piuttosto che dall'intervento manuale. I meccanismi di implementazione garantiscono che le previsioni raggiungano i sistemi a valle in modo affidabile. Il monitoraggio chiude il cerchio, rilevando la deriva e attivando la riqualificazione quando necessario.

Se Flussi di lavoro AI rappresentano ciò che fa l'azienda: instradamento dei ticket, determinazione dei prezzi dei prodotti, valutazione del rischio, generazione di contenuti, quindi i flussi di lavoro della pipeline di intelligenza artificiale rappresentano il modo in cui l'intelligenza viene creata e gestita. Senza una pipeline affidabile dietro le quinte, anche i flussi di lavoro AI più sofisticati si degradano nel tempo e alla fine falliscono.

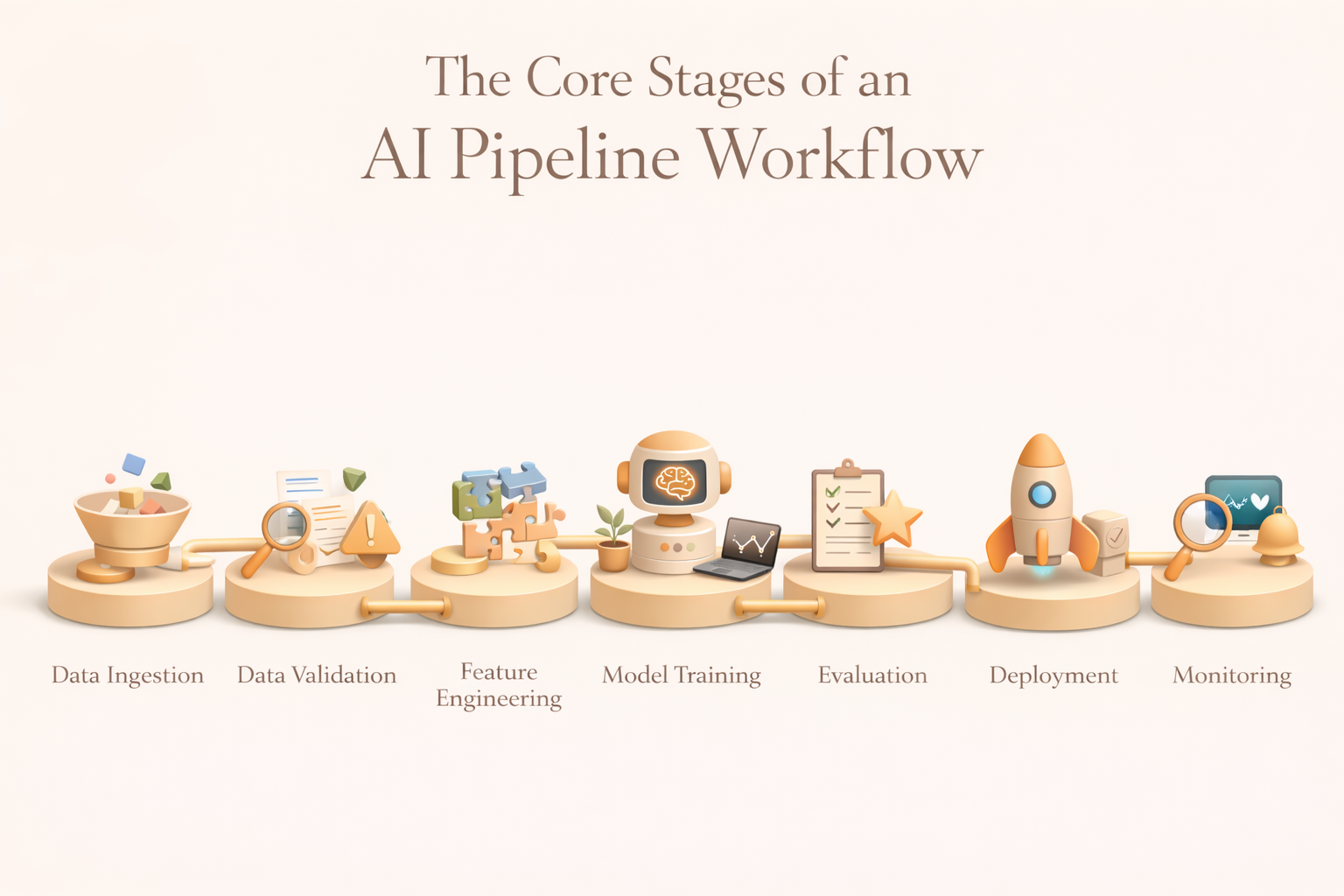

Le fasi principali di un flusso di lavoro di una pipeline di intelligenza artificiale

Sebbene gli strumenti e le implementazioni varino, la maggior parte delle pipeline di IA di produzione segue una struttura coerente. Ogni fase esiste per una ragione e i punti deboli di ogni fase si aggravano a valle.

1. Ingestione di dati

L'inserimento dei dati è il punto di ingresso della pipeline. Il suo ruolo è raccogliere in modo affidabile i dati grezzi da più fonti e consegnarli in un ambiente controllato in cui può avvenire l'elaborazione a valle.

Le fonti tipiche includono database transazionali, flussi di eventi, cloud storage, applicazioni SaaS, registri, sensori e API esterne. L'inserimento efficace gestisce l'evoluzione dello schema, supporta le modalità batch e streaming e fornisce garanzie di consegna e completezza. I team maturi centralizzano l'inserimento in un data lake o in un magazzino per stabilire un'unica fonte di verità e ridurre l'accoppiamento tra i sistemi.

2. Convalida e preelaborazione dei dati

I dati grezzi sono raramente utilizzabili così come sono. La convalida e la preelaborazione proteggono la pipeline da errori silenziosi causati da valori mancanti, deviazioni dello schema, duplicazioni o record danneggiati.

Questa fase impone vincoli di qualità, standardizza i formati, rimuove il rumore e applica trasformazioni in materia di privacy o conformità quando necessario. Fondamentalmente, la convalida è automatizzata. Se le anomalie superano le soglie definite, la pipeline può sospendere l'esecuzione, avvisare i proprietari o indirizzare i dati per la revisione manuale. Questo trasforma la qualità dei dati da un aspetto secondario a una garanzia operativa.

3. Ingegneria delle funzionalità

L'ingegneria delle funzionalità converte i dati puliti in segnali da cui i modelli possono imparare. Ciò può comportare l'aggregazione di eventi in metriche a livello utente, la codifica di variabili categoriali, la generazione di incorporamenti da testo o immagini o il calcolo di statistiche continue su finestre temporali.

Negli ambienti di produzione, l'ingegneria delle funzionalità è raramente ad hoc. I team utilizzano i feature store per standardizzare le definizioni, garantire la coerenza tra formazione e inferenza e consentire il riutilizzo tra i modelli. In questo modo si riduce il debito tecnico e si evitano sottili distorsioni legate alla formazione che possono invalidare le previsioni.

4. Formazione sui modelli

La fase di formazione adatta i modelli utilizzando funzionalità preparate. Ciò include spesso la suddivisione dei set di dati, l'addestramento dei modelli candidati, l'ottimizzazione degli iperparametri e la registrazione degli artefatti.

La formazione può essere eseguita in base a pianificazioni fisse, essere attivata da un nuovo volume di dati o rispondere al degrado delle prestazioni rilevato durante il monitoraggio. È importante sottolineare che i risultati della formazione sono suddivisi in versioni e monitorati in modo che i team possano riprodurre i risultati, verificare le decisioni e ripristinarli quando necessario.

5. Valutazione, governance e approvazione

Prima dell'implementazione, i modelli devono essere valutati in base a criteri tecnici, aziendali ed etici. Ciò include metriche di precisione, controlli di stabilità, valutazioni di equità e vincoli aziendali come le soglie di costo o di rischio.

Molte condotte impongono porte di approvazione in questa fase. Se un modello non soddisfa gli standard predefiniti, l'implementazione viene bloccata automaticamente. Ciò garantisce che la governance sia integrata nella pipeline anziché applicata retroattivamente.

6. Distribuzione

L'implementazione impacchetta i modelli approvati in ambienti in cui possono generare previsioni per sistemi reali. A seconda del caso d'uso, ciò può comportare il punteggio in batch, le API in tempo reale o l'inferenza dello streaming.

I framework di orchestrazione coordinano il servizio dei modelli con le pipeline di dati upstream e le applicazioni downstream. Le strategie di affidabilità, latenza e rollback sono fondamentali in questo caso: gli errori di implementazione influiscono direttamente sui flussi di lavoro aziendali.

7. Monitoraggio, rilevamento della deriva e riqualificazione

Una volta implementata, la pipeline passa alla supervisione continua. Il monitoraggio tiene traccia della deriva dei dati, delle prestazioni del modello, dello stato operativo e dei costi. Quando le metriche peggiorano o le distribuzioni cambiano, vengono attivati flussi di lavoro di riqualificazione per ripristinare le prestazioni.

Questa fase finale trasforma l'IA da un artefatto statico in un sistema vivente che si adatta al cambiamento delle condizioni.

Le fasi della pipeline AI in sintesi

Le migliori pratiche per la progettazione di flussi di lavoro di pipeline di intelligenza artificiale

1. Progetta le pipeline come codice, non come script una tantum

Le pipeline di produzione devono essere controllate, testabili e revisionabili. Trattare le pipeline come codice garantisce riproducibilità, collaborazione e responsabilità. Le definizioni del flusso di lavoro archiviate in Git consentono ai team di tenere traccia delle modifiche, verificare le decisioni e ripristinarle in modo sicuro. Questa disciplina impedisce che le conoscenze istituzionali rimangano intrappolate nei notebook o nei singoli computer.

2. Crea solidi confini di fase con contratti chiari

Ogni fase della pipeline dovrebbe esporre input e output espliciti. Questi contratti rendono i sistemi modulari e riducono i guasti a cascata. Quando i limiti sono chiari, i team possono iterare sui modelli senza interrompere l'acquisizione o sostituire la logica delle funzionalità senza interrompere l'implementazione. Il debug diventa più veloce perché i guasti sono isolati.

3. Inserite il monitoraggio nella pipeline sin dal primo giorno

Il monitoraggio non è un componente aggiuntivo opzionale. Le pipeline dovrebbero emettere parametri per la qualità dei dati, le prestazioni, la latenza e gli errori in ogni fase. I sistemi di avviso devono avvisare i team prima che i guasti abbiano un impatto sugli utenti. I cicli di feedback che raccolgono la verità fondamentale consentono la riqualificazione e il miglioramento continuo. Senza monitoraggio, le tubazioni si deteriorano silenziosamente.

4. Allinea il comportamento della pipeline agli SLA aziendali e ai requisiti del flusso di lavoro

Le pipeline esistono per supportare i flussi di lavoro aziendali. Le interazioni con i clienti in tempo reale richiedono un'inferenza a bassa latenza; la rendicontazione finanziaria può tollerare ritardi in batch. La comprensione anticipata di questi vincoli consente di orientare le scelte infrastrutturali, le strategie di orchestrazione e i compromessi in termini di costi. Le pipeline di successo sono progettate a ritroso in base alle esigenze del flusso di lavoro, non a partire dagli strumenti.

5. Pianifica l'evoluzione, non solo l'implementazione

I sistemi di intelligenza artificiale si evolvono man mano che i dati crescono, i mercati cambiano e i modelli migliorano. Le pipeline devono supportare modifiche allo schema, nuovi segnali e aggiornamenti dei modelli senza riscritture complete. Il design modulare, le interfacce standardizzate e la logica di orchestrazione estensibile proteggono la velocità a lungo termine e riducono i costi di reingegnerizzazione.

Flusso di lavoro della pipeline AI e automazione del flusso di lavoro AI

Conclusione

I flussi di lavoro della pipeline di intelligenza artificiale sono la spina dorsale operativa dell'IA di produzione. Trasformano dati sparsi e modelli sperimentali in sistemi affidabili che consentono decisioni reali su larga scala. Se progettate correttamente, le pipeline riducono i rischi, accelerano l'iterazione e consentono ai flussi di lavoro di intelligenza artificiale di rimanere accurati e affidabili nel tempo.

Man mano che l'intelligenza artificiale viene integrata nel lavoro quotidiano, piattaforme come Kuse svolgono un ruolo complementare portando i risultati della pipeline (riepiloghi, previsioni, approfondimenti) direttamente negli spazi di lavoro collaborativi. Mentre le pipeline gestiscono l'acquisizione, la formazione e il monitoraggio dietro le quinte, Kuse fa emergere l'intelligenza laddove le persone lavorano effettivamente, colmando il divario tra l'infrastruttura di apprendimento automatico e il processo decisionale umano.

Nei moderni sistemi di intelligenza artificiale, le pipeline rendono possibile l'intelligenza, ma un'integrazione ponderata la rende utilizzabile.