AI 管道工作流程:它是什么以及它是如何工作的

了解什么是 AI 管道工作流程,它是如何端到端工作的(从数据摄取到部署和监控),以及如何设计 AI 管道,将可靠的模型交付到生产中,而不仅仅是原型。

什么是 AI 管道工作流程?

AI 管道工作流程是一种结构化的自动化系统,可将原始数据转换为可用于生产的 AI 能力。AI 管道工作流程不依赖于断开连接的脚本、脆弱的笔记本电脑或手动触发的作业,而是定义了一系列可重复的阶段,通过提取、转换、建模、部署和持续监控来可靠地移动数据。

在实践层面上,人工智能管道的存在是为了解决一个非常普遍的问题:实验与生产之间的差距。许多组织可以构建独立运行良好的模型,但能够在实际业务工作流程中持续运行该模型的企业要少得多。AI 管道工作流程通过确保每一个步骤(数据准备、训练、验证、服务和再培训)以一致、可观察的方式大规模运行,从而缩小这一差距。

精心设计的管道将每个阶段视为一个独立但相互关联的系统。数据摄取是自动化的,可以适应上游的变化。验证强制执行质量门控,因此损坏或不完整的数据永远不会到达模型。特征工程已标准化,因此训练和推理保持一致。培训和评估是由数据新鲜度或性能阈值触发的,而不是由手动干预触发的。部署机制确保预测可靠地到达下游系统。监控可以关闭回路,检测偏移并在必要时触发重新训练。

如果 AI 工作流程 代表企业的所作所为——票务路由、产品定价、风险评分、生成内容——然后 AI 管道工作流程代表如何创建和维护情报。如果没有可靠的幕后管道,即使是最复杂的人工智能工作流程也会随着时间的推移而退化并最终失败。

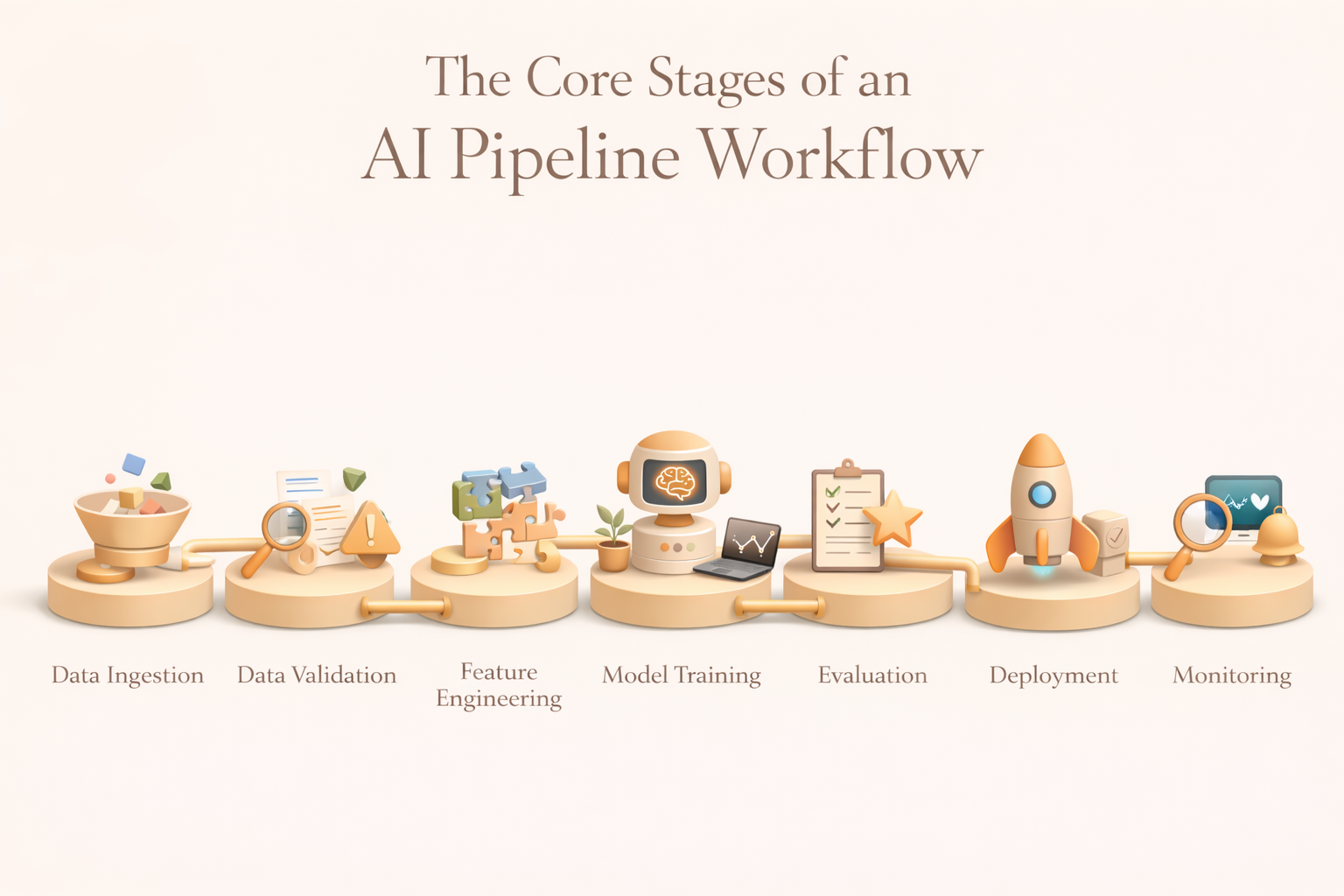

AI 管道工作流程的核心阶段

尽管工具和实现方式各不相同,但大多数生产 AI 管道都遵循一致的结构。每个阶段的存在都是有原因的,任何一个阶段的弱点都会加剧下游。

1。数据摄取

数据摄取是管道的切入点。它的作用是可靠地收集来自多个来源的原始数据,并将其传送到可以进行下游处理的受控环境中。

典型来源包括交易数据库、事件流、云存储、SaaS 应用程序、日志、传感器和外部 API。有效摄取可处理架构演变,支持批处理和流式处理模式,并为交付和完整性提供保障。成熟的团队将摄取集中到数据湖或仓库中,以建立单一事实来源并减少系统之间的耦合。

2。数据验证和预处理

原始数据很少按原样使用。验证和预处理可保护管道免受因缺失值、架构偏差、重复或记录损坏而导致的静默故障。

此阶段强制执行质量限制,标准化格式,消除噪音,并在需要时进行隐私或合规性转换。至关重要的是,验证是自动化的。如果异常超过定义的阈值,则管道可以暂停执行、提醒所有者或传送数据进行人工审查。这将数据质量从事后考虑转变为运营保障。

3.功能工程

特征工程将清理后的数据转换为信号,模型可以从中学习。这可能涉及将事件聚合到用户级指标中,对类别变量进行编码,从文本或图像生成嵌入数据,或者计算时间窗口内的滚动统计数据。

在生产环境中,功能工程很少是临时性的。团队使用功能存储来标准化定义,确保训练和推理之间的一致性,并支持跨模型重复使用。这减少了技术债务,并防止了可能使预测失效的细微培训服务偏差。

4。模型训练

训练阶段使用准备好的特征拟合模型。这通常包括数据集拆分、候选模型训练、超参数优化和工件记录。

训练可以按固定的时间表运行,由新的数据量触发,或者对监控中检测到的性能下降做出响应。重要的是,培训输出经过版本控制和跟踪,因此团队可以重现结果、审计决策并在必要时进行回滚。

5。评估、治理和批准

在部署之前,必须根据技术、业务和道德标准对模型进行评估。这包括准确性指标、稳定性检查、公平性评估和业务限制,例如成本或风险阈值。

在现阶段,许多管道都强制执行批准门禁。如果模型无法满足预定义的标准,则会自动阻止部署。这可确保将治理纳入管道中,而不是追溯执行。

6。部署

部署将批准的模型打包到环境中,在那里它们可以为真实系统生成预测。视用例而定,这可能涉及批量评分、实时 API 或流式推理。

编排框架协调上游数据管道和下游应用程序的模型服务。可靠性、延迟和回滚策略在这里至关重要,部署失败直接影响业务工作流程。

7。监测、漂移检测和再训练

一旦部署,管道将转向持续监督。监控跟踪数据漂移、模型性能、运营状况和成本。当指标下降或分布发生变化时,将触发重新训练工作流程以恢复性能。

最后阶段将人工智能从静态人工制品转变为可随着条件变化而适应的生命系统。

AI 管道阶段一览

设计 AI 管道工作流程的最佳实践

1。将管道设计为代码,而不是一次性脚本

生产管道必须是版本控制、可测试和可审查的。将管道视为代码可确保可重复性、协作性和问责性。存储在 Git 中的工作流程定义允许团队跟踪更改、审计决策和安全回滚。该学科可防止机构知识被困在笔记本电脑或个人计算机中。

2。通过明确的合同创造强大的舞台界限

每个流水线阶段都应公开明确的输入和输出。这些合同使系统模块化并减少级联故障。当界限明确时,团队可以在不中断采集的情况下迭代模型,或者在不中断部署的情况下替换功能逻辑。由于故障是隔离的,调试变得更快。

3.从第一天起就将监控纳入管道

监控不是可选的附加组件。管道应在每个阶段发布数据质量、性能、延迟和错误的指标。警报系统必须在故障影响用户之前通知团队。捕捉真实情况的反馈回路可以实现再培训和持续改进。如果不进行监控,管道就会悄然衰变。

4。使管道行为与业务 SLA 和工作流程要求保持一致

管道的存在是为了支持业务工作流程。实时客户互动需要低延迟推断;财务报告可能会容忍批量延迟。事先了解这些限制因素可以为基础架构选择、协调策略和成本权衡提供依据。成功的管道是根据工作流程需求向后设计的,而不是从工具向前设计的。

5。制定演进计划,而不仅仅是部署

随着数据的增长、市场的变化和模型的改进,人工智能系统不断发展。管道必须支持架构更改、新信号和模型升级,无需进行全面重写。模块化设计、标准化接口和可扩展的编排逻辑可保护长期速度并降低再设计成本。

AI 管道工作流程与 AI 工作流程自动化

结论

AI 管道工作流程是生产 AI 的运营支柱。它们将分散的数据和实验模型转换为可靠的系统,为大规模的实际决策提供动力。如果设计得当,管道可以降低风险,加速迭代,并使 AI 工作流程能够随着时间的推移保持准确和可信。

随着人工智能融入日常工作,诸如此类的平台 久世市 通过将管道输出(摘要、预测、见解)直接引入协作工作空间来发挥补充作用。Pipelines 在幕后处理摄取、训练和监控,而 Kuse 则在人们实际工作的地方展示情报,弥合了机器学习基础设施与人类决策之间的差距。

在现代 AI 系统中,管道使智能成为可能,但深思熟虑的集成使其变得可用。