Fluxo de trabalho do AI Pipeline: o que é e como funciona

Saiba o que é um fluxo de trabalho de pipeline de IA, como ele funciona de ponta a ponta, desde a ingestão de dados até a implantação e o monitoramento, e como projetar pipelines de IA que enviam modelos confiáveis para a produção, não apenas protótipos.

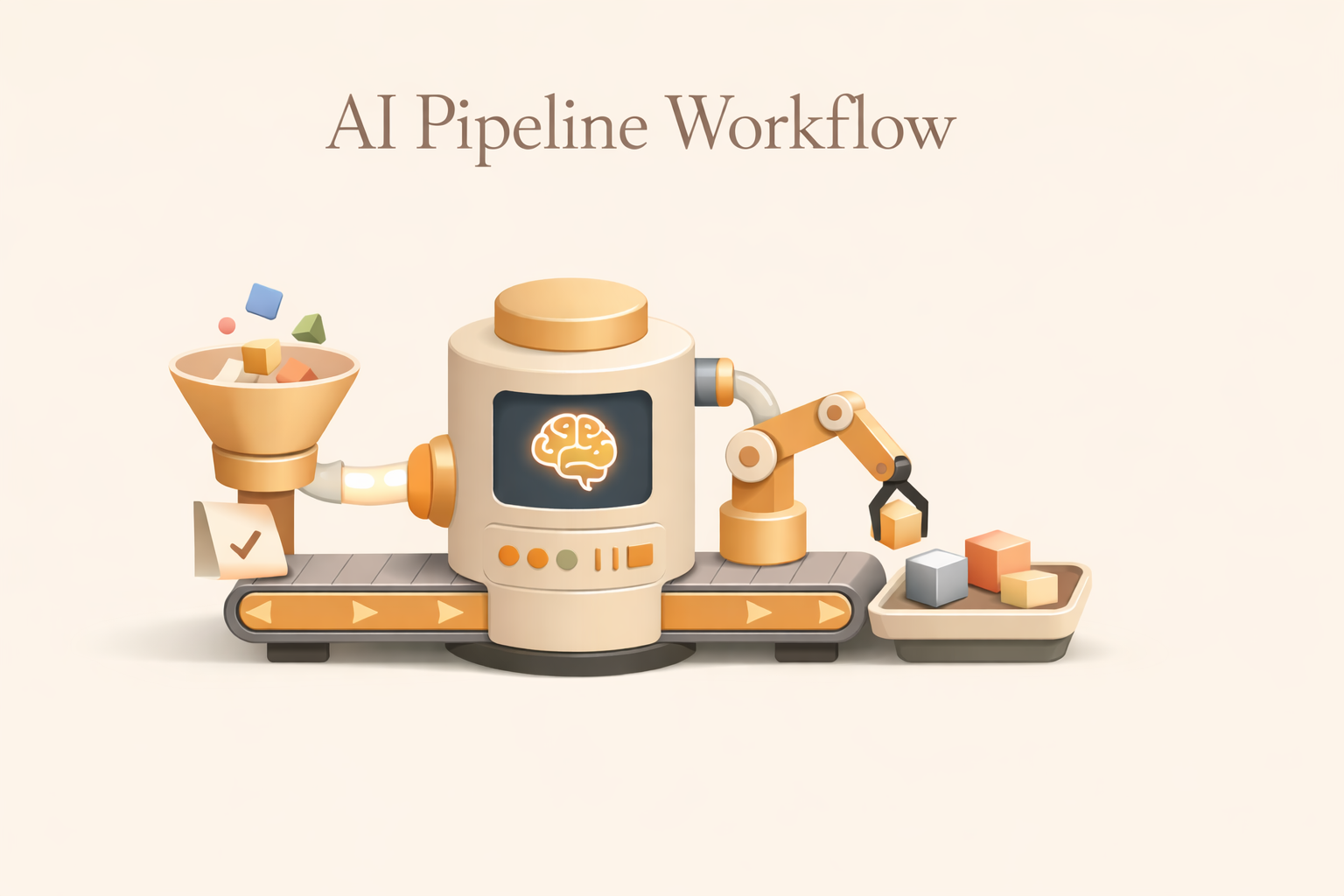

O que é um fluxo de trabalho de pipeline de IA?

Um fluxo de trabalho de pipeline de IA é o sistema estruturado e automatizado que transforma dados brutos em um recurso de IA pronto para produção. Em vez de depender de scripts desconectados, notebooks frágeis ou tarefas acionadas manualmente, um fluxo de trabalho de pipeline de IA define uma sequência repetível de estágios que movem dados de forma confiável por meio de ingestão, transformação, modelagem, implantação e monitoramento contínuo.

Em um nível prático, os pipelines de IA existem para resolver um problema muito comum: a lacuna entre experimentação e produção. Muitas organizações podem criar um modelo que funcione bem de forma isolada, mas muito poucas podem operar esse modelo continuamente dentro de fluxos de trabalho reais de negócios. Um fluxo de trabalho de pipeline de IA preenche essa lacuna ao garantir que cada etapa — preparação de dados, treinamento, validação, atendimento e reciclagem — seja executada de forma consistente, observável e em grande escala.

Uma tubulação bem projetada trata cada fase como um sistema independente, mas conectado. A ingestão de dados é automatizada e resistente às mudanças anteriores. A validação impõe barreiras de qualidade para que dados corrompidos ou incompletos nunca cheguem aos modelos. A engenharia de recursos é padronizada para que o treinamento e a inferência permaneçam alinhados. O treinamento e a avaliação são acionados pela atualização dos dados ou por limites de desempenho, em vez de intervenção manual. Os mecanismos de implantação garantem que as previsões cheguem aos sistemas posteriores de forma confiável. O monitoramento fecha o ciclo, detectando desvios e acionando o retreinamento quando necessário.

Se Fluxos de trabalho de IA representam o que a empresa faz — roteamento de tickets, preços de produtos, pontuação de risco, geração de conteúdo — e os fluxos de trabalho do pipeline de IA representam como a inteligência é criada e mantida. Sem um canal confiável nos bastidores, até mesmo os fluxos de trabalho de IA mais sofisticados se degradam com o tempo e acabam falhando.

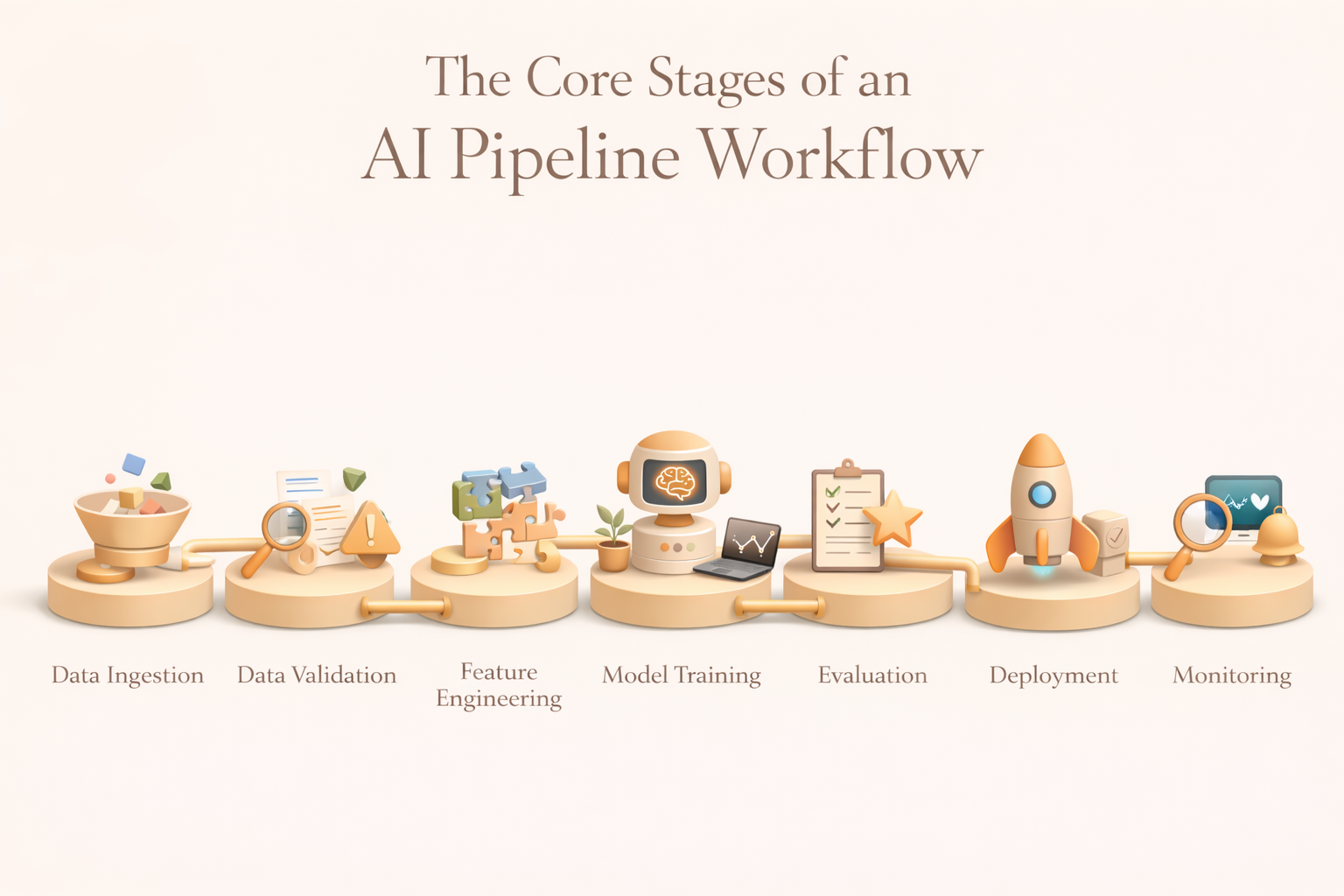

Os principais estágios de um fluxo de trabalho de pipeline de IA

Embora as ferramentas e implementações variem, a maioria dos pipelines de IA de produção segue uma estrutura consistente. Cada estágio existe por uma razão — e pontos fracos em qualquer estágio composto a jusante.

1. Ingestão de dados

A ingestão de dados é o ponto de entrada do pipeline. Sua função é coletar dados brutos de várias fontes de forma confiável e entregá-los em um ambiente controlado onde o processamento posterior pode ocorrer.

As fontes típicas incluem bancos de dados transacionais, fluxos de eventos, armazenamento em nuvem, aplicativos SaaS, registros, sensores e APIs externas. A ingestão eficaz lida com a evolução do esquema, oferece suporte aos modos de lote e streaming e oferece garantias de entrega e integridade. Equipes maduras centralizam a ingestão em um data lake ou armazém para estabelecer uma fonte única de verdade e reduzir o acoplamento entre sistemas.

2. Validação e pré-processamento de dados

Os dados brutos raramente podem ser usados no estado em que se encontram. A validação e o pré-processamento protegem o pipeline contra falhas silenciosas causadas por valores ausentes, desvio de esquema, duplicação ou registros corrompidos.

Esse estágio impõe restrições de qualidade, padroniza formatos, remove ruídos e aplica transformações de privacidade ou conformidade quando necessário. Fundamentalmente, a validação é automatizada. Se as anomalias excederem os limites definidos, o pipeline poderá pausar a execução, alertar os proprietários ou encaminhar os dados para análise manual. Isso transforma a qualidade dos dados de uma reflexão tardia em uma garantia operacional.

3. Engenharia de recursos

A engenharia de recursos converte dados limpos em sinais com os quais os modelos podem aprender. Isso pode envolver a agregação de eventos em métricas no nível do usuário, a codificação de variáveis categóricas, a geração de incorporações a partir de texto ou imagens ou o cálculo de estatísticas contínuas em janelas de tempo.

Em ambientes de produção, a engenharia de recursos raramente é ad hoc. As equipes usam repositórios de recursos para padronizar as definições, garantir a consistência entre treinamento e inferência e permitir a reutilização em todos os modelos. Isso reduz a dívida técnica e evita uma distorção sutil no serviço de treinamento, que pode invalidar as previsões.

4. Treinamento de modelos

O estágio de treinamento se ajusta aos modelos usando recursos preparados. Isso geralmente inclui divisão de conjuntos de dados, treinamento de modelos candidatos, otimização de hiperparâmetros e registro de artefatos.

O treinamento pode ser executado em horários fixos, ser acionado por um novo volume de dados ou responder à degradação do desempenho detectada no monitoramento. É importante ressaltar que os resultados do treinamento são controlados e controlados para que as equipes possam reproduzir resultados, auditar decisões e reverter quando necessário.

5. Avaliação, governança e aprovação

Antes da implantação, os modelos devem ser avaliados de acordo com critérios técnicos, comerciais e éticos. Isso inclui métricas de precisão, verificações de estabilidade, avaliações de imparcialidade e restrições comerciais, como limites de custo ou risco.

Muitos oleodutos impõem portas de aprovação neste estágio. Se um modelo não atender aos padrões predefinidos, a implantação será bloqueada automaticamente. Isso garante que a governança seja incorporada ao pipeline, em vez de aplicada retroativamente.

6. Implantação

Os pacotes de implantação aprovaram modelos em ambientes nos quais eles podem gerar previsões para sistemas reais. Dependendo do caso de uso, isso pode envolver pontuação em lote, APIs em tempo real ou inferência de streaming.

As estruturas de orquestração coordenam o serviço de modelos com pipelines de dados upstream e aplicativos downstream. As estratégias de confiabilidade, latência e reversão são essenciais aqui — as falhas na implantação afetam diretamente os fluxos de trabalho dos negócios.

7. Monitoramento, detecção de deriva e reciclagem

Uma vez implantado, o gasoduto passa para uma supervisão contínua. O monitoramento rastreia o desvio de dados, o desempenho do modelo, a integridade operacional e o custo. Quando as métricas se degradam ou as distribuições mudam, fluxos de trabalho de reciclagem são acionados para restaurar o desempenho.

Esse estágio final transforma a IA de um artefato estático em um sistema vivo que se adapta à medida que as condições mudam.

Visão geral dos estágios do AI Pipeline

Melhores práticas para projetar fluxos de trabalho de pipeline de IA

1. Projete pipelines como código — não scripts pontuais

Os pipelines de produção devem ser versionados, testáveis e revisáveis. Tratar pipelines como código garante reprodutibilidade, colaboração e responsabilidade. As definições de fluxo de trabalho armazenadas no Git permitem que as equipes acompanhem mudanças, auditem decisões e revertam com segurança. Essa disciplina evita que o conhecimento institucional fique preso em cadernos ou máquinas individuais.

2. Crie limites de estágio fortes com contratos claros

Cada estágio do pipeline deve expor entradas e saídas explícitas. Esses contratos tornam os sistemas modulares e reduzem as falhas em cascata. Quando os limites são claros, as equipes podem repetir os modelos sem interromper a ingestão ou substituir a lógica dos recursos sem interromper a implantação. A depuração se torna mais rápida porque as falhas são isoladas.

3. Monitoramento de panificação na tubulação desde o primeiro dia

O monitoramento não é um complemento opcional. Os pipelines devem emitir métricas de qualidade de dados, desempenho, latência e erros em todas as etapas. Os sistemas de alerta devem notificar as equipes antes que as falhas afetem os usuários. Os ciclos de feedback que capturam a verdade básica permitem a reciclagem e a melhoria contínua. Sem monitoramento, os dutos se deterioram silenciosamente.

4. Alinhe o comportamento do pipeline com os SLAs comerciais e os requisitos de fluxo de trabalho

Os pipelines existem para dar suporte aos fluxos de trabalho de negócios. As interações com os clientes em tempo real exigem inferência de baixa latência; os relatórios financeiros podem tolerar atrasos em lotes. A compreensão antecipada dessas restrições informa as escolhas de infraestrutura, as estratégias de orquestração e as compensações de custos. Os pipelines bem-sucedidos são projetados de trás para frente a partir das necessidades do fluxo de trabalho, não para frente a partir das ferramentas.

5. Planeje a evolução, não apenas a implantação

Os sistemas de IA evoluem à medida que os dados crescem, os mercados mudam e os modelos melhoram. Os pipelines devem suportar mudanças de esquema, novos sinais e atualizações de modelo sem reescritas completas. Design modular, interfaces padronizadas e lógica de orquestração extensível protegem a velocidade de longo prazo e reduzem os custos de reengenharia.

Fluxo de trabalho do AI Pipeline versus automação do fluxo de trabalho

Conclusão

Os fluxos de trabalho do pipeline de IA são a espinha dorsal operacional da IA de produção. Eles transformam dados dispersos e modelos experimentais em sistemas confiáveis que potencializam decisões reais em grande escala. Quando bem projetados, os pipelines reduzem o risco, aceleram a iteração e permitem que os fluxos de trabalho de IA permaneçam precisos e confiáveis ao longo do tempo.

À medida que a IA se torna incorporada ao trabalho diário, plataformas como Kuse desempenhe um papel complementar ao trazer os resultados do pipeline — resumos, previsões, insights — diretamente para os espaços de trabalho colaborativos. Enquanto os pipelines lidam com a ingestão, o treinamento e o monitoramento nos bastidores, Kuse mostra a inteligência onde as pessoas realmente trabalham, preenchendo a lacuna entre a infraestrutura de aprendizado de máquina e a tomada de decisões humanas.

Nos sistemas modernos de IA, os pipelines possibilitam a inteligência, mas uma integração cuidadosa a torna utilizável.