Como a IA Human in the Loop realmente funciona

A IA humana integrada mantém as pessoas na cadeia de decisão em que os algoritmos atingem seus limites. Veja como o HITL funciona e por que é importante.

A IA humana in the loop é um modelo em que as pessoas participam ativamente do treinamento, operação ou supervisão de um sistema de inteligência artificial, em vez de deixá-lo funcionar de forma autônoma.

O conceito vem de contextos militares, de aviação e de energia nuclear, onde os sistemas automatizados precisavam da capacidade de intervenção humana para evitar desastres. Um piloto pode anular o piloto automático. Um controlador pode abortar uma sequência de lançamento. O humano permanece na cadeia de decisão.

A IA emprestou essa estrutura porque os modelos de aprendizado de máquina enfrentam problemas semelhantes. Eles funcionam de forma brilhante dentro de seus parâmetros de treinamento. Eles enfrentam casos extremos, ambigüidades e situações que seus dados de treinamento não cobriam. O Human in the loop resolve essa lacuna inserindo o julgamento humano onde os algoritmos atingem seus limites.

A abordagem reconhece algo importante. A IA não deve substituir os humanos. A IA deve aumentar as capacidades humanas. A combinação supera o desempenho de qualquer um trabalhando sozinho.

Como a IA Human in the Loop realmente funciona

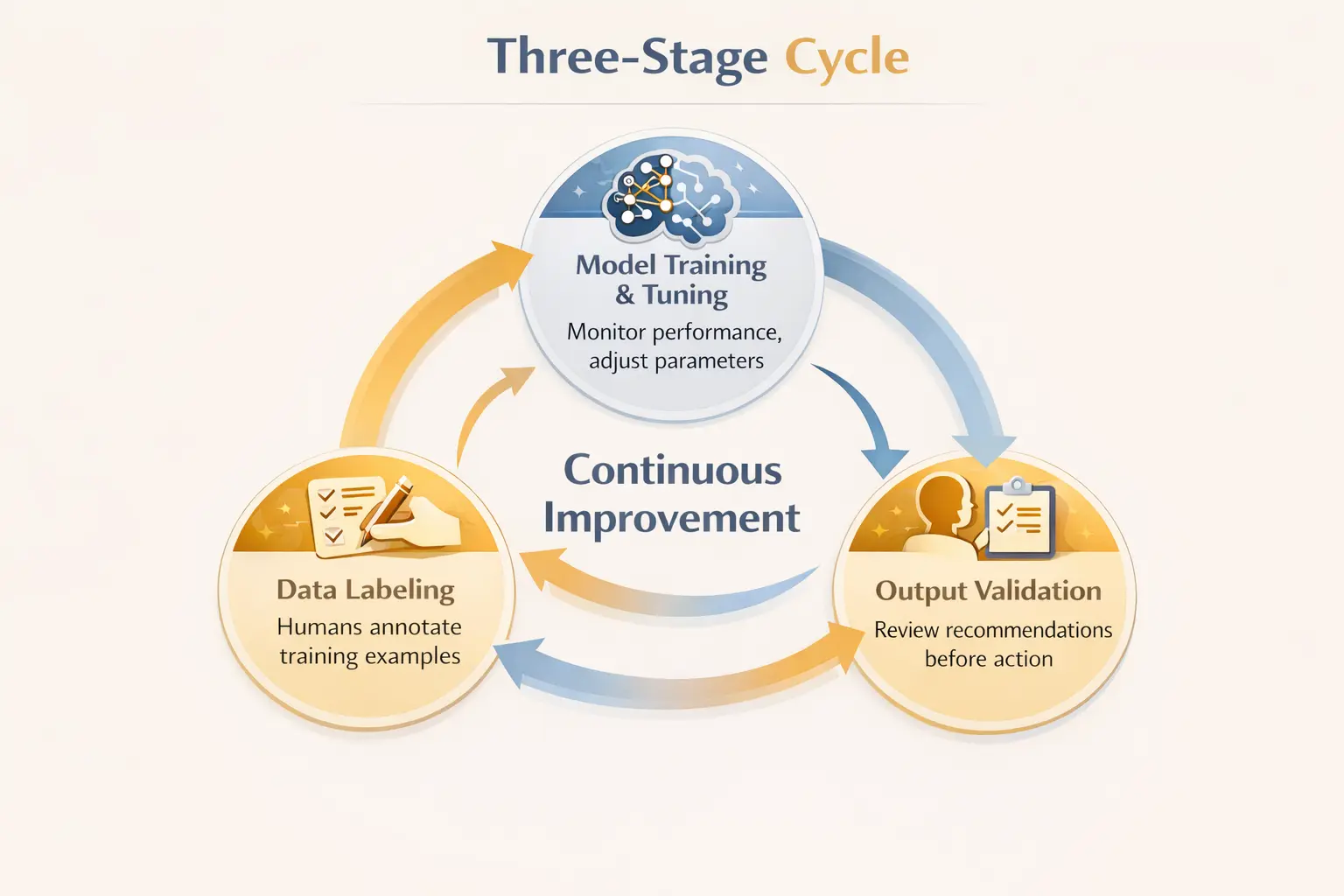

O HITL cria um ciclo de feedback entre humanos e máquinas. Esse ciclo opera em três estágios do ciclo de vida da IA.

A primeira etapa envolve a rotulagem de dados. Os modelos de aprendizado de máquina aprendem com exemplos. Alguém deve rotular esses exemplos corretamente. No aprendizado supervisionado, os humanos anotam os dados de treinamento para ensinar ao modelo qual é a aparência de “spam” versus “não spam”, ou quais pixels em uma imagem representam um tumor versus um tecido saudável. De acordo com IBM , essa anotação humana pode ser lenta e cara para grandes conjuntos de dados, mas cria a base que possibilita o aprendizado de máquina.

A segunda etapa envolve o treinamento e o ajuste do modelo. Os humanos monitoram o desempenho do modelo. Eles pontuam resultados. Eles identificam onde as previsões dão errado. Eles ajustam os parâmetros. O modelo melhora com base nesse feedback humano, em vez de apenas analisar mais dados.

A terceira etapa envolve a validação da saída. Antes que as recomendações de IA cheguem aos usuários finais ou acionem ações, os humanos as revisam. Um médico verifica um diagnóstico de IA. Um moderador de conteúdo analisa as postagens sinalizadas. Um analista financeiro valida sinais de negociação algorítmica. A supervisão humana detecta erros antes que eles causem danos.

Esse envolvimento em três estágios cria uma melhoria contínua. O modelo fica melhor. Os revisores humanos aprendem quais erros devem ser observados. O sistema como um todo se torna mais confiável do que qualquer componente sozinho.

Por que o Human in the Loop é importante para sistemas de IA

Várias forças tornam o HITL essencial em vez de opcional.

Os modelos de IA incorporam preconceitos de seus dados de treinamento. Os dados históricos de contratação refletem a discriminação anterior. Os conjuntos de dados médicos sub-representam certas populações. Os modelos financeiros perpetuam as desigualdades existentes. Os revisores humanos podem identificar quando os resultados refletem esses preconceitos e intervir antes que as recomendações tendenciosas cheguem às pessoas afetadas.

Casos extremos derrotam sistemas puramente automatizados. As situações do mundo real nem sempre coincidem com os cenários de treinamento. Um carro autônomo encontra condições climáticas que nunca viu. Uma IA médica enfrenta uma combinação de sintomas fora de seu conjunto de treinamento. O reconhecimento visual de um caixa eletrônico não consegue ler um cheque escrito à mão. O Human in the loop fornece capacidade de fallback quando a automação atinge seus limites.

A responsabilidade exige envolvimento humano. Quando a IA comete erros, alguém deve ser responsável. Sistemas puramente autônomos criam lacunas de responsabilidade. O HITL garante que os humanos permaneçam na cadeia de decisão para escolhas consequentes, preservando linhas claras de responsabilidade.

Algumas decisões exigem um raciocínio ético que os algoritmos não podem fornecer. Colaboração humana com IA torna-se essencial quando as escolhas envolvem valores, compensações ou contexto que não podem ser reduzidos a funções de otimização. Humanos trazem julgamento. A IA traz poder de processamento. Juntos, eles lidam com problemas que nenhum deles poderia resolver sozinhos.

O ser humano em todos os setores

O HITL aparece sempre que a IA toca decisões de alto risco.

O setor de saúde fornece exemplos claros. A IA pode analisar imagens médicas, sugerir diagnósticos e recomendar tratamentos. Mas os médicos analisam esses resultados antes de agir sobre eles. UM Editorial da Nature Medicine observou que 58% dos médicos se preocupam com a dependência excessiva da IA para o diagnóstico. O HITL aborda essa preocupação mantendo o julgamento clínico central enquanto usa a IA para aprimorar os recursos de diagnóstico.

A moderação de conteúdo combina a detecção de IA com a revisão humana. Algoritmos sinalizam conteúdo potencialmente problemático em grande escala. Moderadores humanos tomam decisões finais em casos ambíguos em que o contexto é importante. O volume requer automação. A nuance exige julgamento humano.

Os serviços financeiros usam o HITL para detecção e conformidade de fraudes. Os sistemas de IA sinalizam transações suspeitas. Analistas humanos investigam as bandeiras antes de congelar contas ou relatar atividades. Falsos positivos prejudicariam clientes inocentes. Falsos negativos permitiriam o crime. A revisão humana equilibra esses riscos.

Os veículos autônomos representam a evolução da implementação do HITL. Os sistemas atuais exigem que motoristas humanos assumam o controle em determinadas situações. A IA lida com a condução rotineira. Humanos lidam com exceções. À medida que a tecnologia melhora, os limites mudam, mas a supervisão humana continua fazendo parte da arquitetura de segurança.

O atendimento ao cliente combina cada vez mais chatbots de IA com a escalação humana. Os bots lidam com consultas de rotina com eficiência. Questões complexas ou delicadas são transferidas para agentes humanos. A abordagem híbrida atende a mais clientes e, ao mesmo tempo, preserva a conexão humana onde é mais importante.

Os desafios do Human in the Loop

O HITL tem inconvenientes.

O envolvimento humano cria gargalos. A IA pode processar milhares de itens por segundo. A revisão humana processa itens por minuto, na melhor das hipóteses. Escalar o HITL significa contratar muitos revisores ou aceitar que apenas uma amostra dos resultados da IA receba atenção humana.

O custo aumenta significativamente. A anotação humana para grandes conjuntos de dados exige milhares de horas de trabalho. Os revisores especializados em áreas especializadas, como medicina ou direito, custam ainda mais. As organizações devem equilibrar os ganhos de precisão com as restrições orçamentárias.

Os revisores humanos também cometem erros. Fadiga, distração e preconceitos cognitivos afetam o julgamento humano. A dependência excessiva das recomendações da IA pode entorpecer a atenção humana. O artigo da Nature Medicine observou uma pesquisa preocupante que mostra que endoscopistas que usaram assistência de IA por três meses viram suas próprias taxas de detecção diminuírem após a interrupção. As habilidades humanas podem atrofiar quando a IA lida demais.

As preocupações com a privacidade surgem quando humanos analisam dados confidenciais. Registros médicos, informações financeiras, comunicações pessoais. O acesso desses dados por revisores humanos cria um risco de exposição adicional, além do que os sistemas automatizados por si só criariam.

Onde o Kuse AI se encaixa nos fluxos de trabalho do Human in the Loop

A IA humana in the loop gera conhecimento em todas as etapas. Diretrizes de anotação. Notas de desempenho do modelo. Documentação do caso Edge. Feedback do revisor. Justificativa de decisão para resultados anulados.

Esse conhecimento se espalha por planilhas, documentos de treinamento, wikis internos e notas individuais dos revisores. Encontrar o que você precisa se torna seu próprio desafio. Por que rotulamos essa categoria dessa forma? Quais casos extremos esse modelo enfrentou dificuldades? Como os revisores devem lidar com essa situação ambígua?

Kuse organiza esse conhecimento operacional para que as equipes do HITL encontrem respostas sem vasculhar a documentação dispersa. Quando um novo revisor precisa de diretrizes de anotação, elas estão acessíveis. Quando o retreinamento de modelos exige casos extremos documentados, os exemplos existem em um só lugar. Quando alguém questiona uma decisão de rotulagem, a justificativa é fácil de encontrar.

Os fluxos de trabalho do Human in the loop funcionam de forma mais suave quando o conhecimento que eles geram permanece organizado e acessível.

Conclusão

A IA humana in the loop representa um meio termo prático entre a automação total e os processos manuais. As máquinas lidam com escala e consistência. Os humanos fornecem julgamento, ética e tratamento de casos extremos.

A abordagem funciona porque aproveita os pontos fortes de ambas. A IA processa grandes quantidades de dados rapidamente. Os humanos captam o que a automação não percebe. O feedback entre eles melhora continuamente o sistema.

O HITL não é um estágio temporário antes da autonomia total da IA. É um modelo sustentável para domínios em que as decisões são muito importantes para serem deixadas inteiramente para algoritmos. Diagnóstico de saúde. Moderação de conteúdo. Conformidade financeira. Segurança de veículos autônomos. Essas áreas provavelmente sempre envolverão humanos no circuito, porque os riscos exigem o julgamento humano como apoio.

A questão não é se devemos manter os humanos informados. A questão é como projetar esse envolvimento de forma eficaz. Onde no fluxo de trabalho? Quanta avaliação? Qual treinamento para revisores? Quais ferramentas para apoiá-los?

As organizações que respondem bem a essas perguntas obtêm os benefícios da capacidade de IA com a confiabilidade da supervisão humana. Aqueles que não correm o risco de falhas de automação ou de gargalos de revisão insustentáveis.